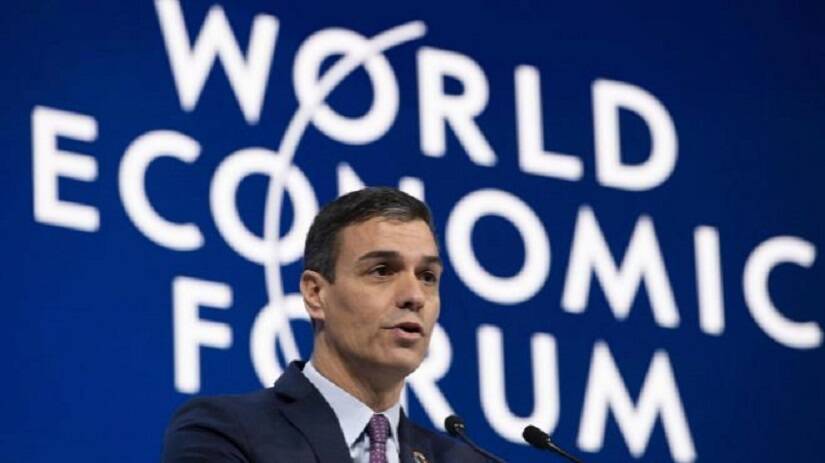

A medida que fracasa a ojos vista el proyecto globalista en todo el planeta, desde Estados Unidos a Sri Lanka pasando por Holanda y toda la Unión Europea, se hace cada vez más imperativo limitar las informaciones incómodas, la disidencia en medios y redes sociales y las «opiniones odiosas». Por eso el Foro Económico Mundial, más conocido como Foro de Davos, propone hacer frente a las malas noticias con una censura automatizada.

Es la solución que se avanza en un artículo aparecido en la web del foro, titulado «¿La solución al abuso online? La Inteligencia Artificial más la inteligencia humana», cuya tesis, una vez que se expurga el texto de sus eufemismos buenistas, es que ni los algoritmos por sí solos ni la vigilancia de los censores humanos bastan para mantenernos a oscuras sobre lo que está pasando y no conviene que conozcamos, o sobre perspectivas y voces contrarias al pensamiento único.

Es evidente que la riada de información que se vierte a diario en redes sociales por parte de cientos de millones de usuarios hace imposible que un equipo de censores humanos, por gigantesco que sea, pueda controlarla y expurgarla. Eso es lo que ha hecho necesario a las tecnológicas recurrir al famoso/infame «algoritmo», es decir, patrones de lenguaje que puede reconocer y denunciar un programa de inteligencia artificial.

Pero las máquinas son solo máquinas, por muy listas que sean, y resultan incapaces de detectar las mil y una formas a las que recurren los usuarios que quieren burlar la censura, desde las faltas de ortografía deliberadas, el empleo de signos, la separación de letras de la palabra o palabras prohibidas y otras aún más ingeniosas. Por eso el foro propone combinar el poder de la máquina con la inteligencia humana, haciendo que ambas se refuercen mutuamente y «aprendan» una de la otra.

«Combinando de la manera adecuada el poder de las últimas tecnologías, la recopilación de datos a partir de las plataformas y la destreza de los expertos en la materia -que entienden cómo operan los perpetradores de amenazas-, la detección escalada del abuso en línea puede alcanzar una precisión casi perfecta», dice el foro.

Las vueltas que da el autor para aclarar de qué está hablando realmente (y que, naturalmente, no se aplica solo ni especialmente a «amenazas») son tales que hay que avanzar en el artículo para llegar al meollo: “Al prestar la información multilingüe y cribada por seres humanos de la plataforma a la Inteligencia Artificial, esta podrá detectar abusos nuevos y matizados antes de que lleguen a las principales plataformas. Complementar esta detección automatizada más inteligente con la experiencia humana para revisar casos extremos e identificar falsos positivos y negativos y luego volver a introducir esos hallazgos en conjuntos de entrenamiento nos permitirá crear IA con inteligencia humana integrada”.

Desde aquí nos preguntamos cuánto tiempo tardará la inteligencia artificial en detectar la ironía, porque quizá en no demasiado tiempo sea lo único que nos quede para expresarnos en libertad.

© La Gaceta de la Iberosfera

Comentarios